Bonjour,

Je souhaite avoir un retour d’expérience concernant la récupération de jeux de données via une API. Quelle méthode privilégiez-vous pour intégrer des données provenant d'une plateforme externe (notamment lorsque les données sont volumineuses) ?

Plusieurs approches sont possibles :

- Télécharger toutes les données et ajouter ensuite une nouvelle source.

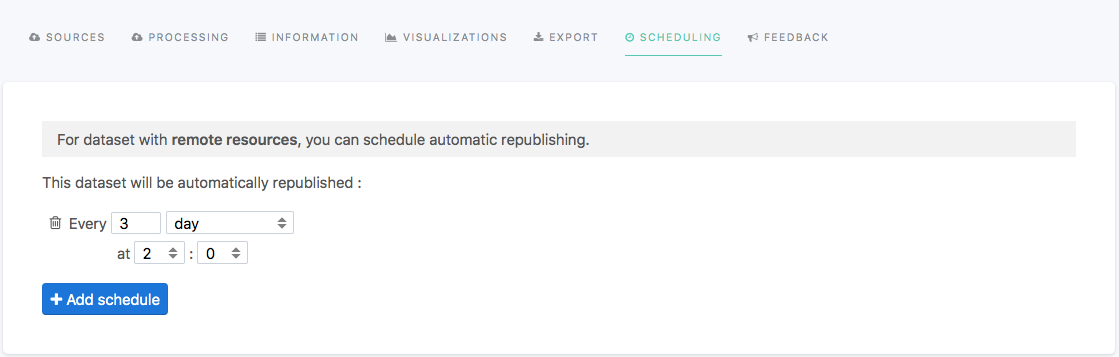

- Ajouter une URL de téléchargement via une requête API, cependant cette méthode pose des problèmes en ce qui concerne la mise à jour régulière des jeux de données, nécessitant une veille constante.

- Passer par des serveurs internes afin de mettre en place une récupération automatique des données, puis ajouter une source qui puise les données sur le serveur. Il est à noter que ces données sont très volumineuses, et que le système d'API repose sur la pagination en profondeur.

Quelles sont vos pratiques à ce sujet ? À titre d'exemple, prenons les données provenant de l'ADEME sur les DPE.

Dans l'attente de vos retours et de vos expériences partagées,

Cordialement,

Auto-translation 🪄

Hello, I would like to have some feedback regarding the retrieval of datasets via an API. What method do you prefer to integrate data from an external platform (especially when the data is large)? Several approaches are possible: Download all the data and then add a new source. Add a download URL via an API request, however this method poses problems regarding regular updating of datasets, requiring constant monitoring. Go through internal servers to set up automatic data recovery, then add a source that draws the data from the server. It should be noted that this data is very voluminous, and that the API system relies on deep paging. What are your practices on this subject? As an example, let's take the data from ADEME on DPE. Looking forward to your feedback and experiences